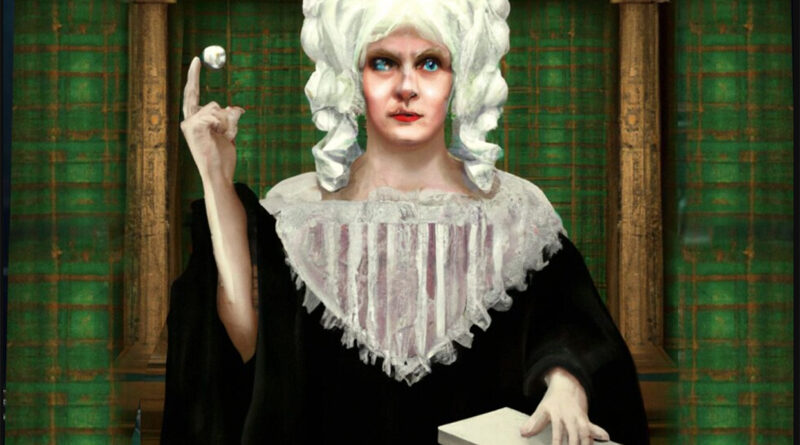

Cuando los DDHH se convierten en un juego de lotería impulsado por la IA

Juan Ortiz Freuler, doctorando en la Escuela de Comunicación y Periodismo Annenberg de la estadounidense Universidad del Sur de California y remero del movimiento tecnológico no alineado

Las aplicaciones de inteligencia artificial (IA) como ChatGPT están normalizando un giro probabilístico en la visión Occidental del mundo; este giro promueve la aceptación de la incertidumbre a través del pensamiento probabilístico y eleva la estadística y el modelado complejo como aproximaciones al conocimiento.

Con el despliegue de ChatGPT, por ejemplo, el propio lenguaje humano se replantea como un sistema de meras probabilidades, una lotería en la cual la verdad y los hechos son meros participantes.

Esto explica por qué ChatGPT mezcla de forma sistemática y confiada la verdad con ficciones plausibles, alucinaciones que se espera que aceptemos como un efecto secundario inevitable que será menos incómodo una vez que adoptemos plenamente la visión probabilística del mundo.

Este cambio hacia una visión probabilística del mundo es una lenta corriente subterránea que ha ido ganando terreno en las últimas décadas y, como tal, es a la vez más generalizada y menos tangible que gran parte del marco tecnológico que domina el ciclo de noticias. Este cambio probabilístico se basa en el cambio cuantitativo que se viene produciendo desde los años setenta tanto en el gobierno como en el mundo académico.

El enfoque probabilístico lleva décadas presente en los sistemas de scoring (por ejemplo, de crédito o de seguros) y cada vez está más presente en la vida cotidiana. En esencia, estos sistemas evalúan el comportamiento no observado de ciertos individuos proyectando sobre ellos el comportamiento observado de individuos que comparten determinadas características que el programa y los diseñadores de su sistema consideran relevantes y, por tanto, reciben el mismo trato o un trato similar.

Gracias al despliegue de sensores en los dispositivos personales, como smartphones, y al aumento del tiempo que se pasa en entornos virtuales fuertemente vigilados, la elección de las características que se utilizan para definir los límites de estos grupos construidos de manera artificial se ha vuelto cada vez más granular y abstracta.

Por ejemplo, podríamos imaginar que un modelos predictivos creara la agrupación X98899T2, que reúne a todas las personas que en algún momento han visitado un sitio web de un determinado champú, han estado en un aeropuerto una vez en los últimos seis meses, tienen entre 40 y 55 años y poseen un iPhone, siempre y cuando se demuestre estadísticamente que esta colección aparentemente aleatoria de características es buena predictora de algún otro comportamiento, como comprar un perfume de la marca X.

Las categorías que tradicionalmente han sido fundamentales para ordenar la vida humana, como la edad y el sexo, pierden relevancia a medida que estas segmentaciones abstractas, sin etiquetar y hechas a medida, destinadas a informar decisiones no humanas sino informáticas, ocupan su lugar.

Una reciente investigación de Markup reveló un archivo con 650 000 etiquetas discretas utilizadas por los anunciantes para categorizar a las personas. Para poner esta cifra en contexto, son más de dos etiquetas por cada una de las 270 000 palabras definidas en el Oxford English Dictionary.

Como resultado, el destino de algo como si recibimos o no un anuncio para un alquiler o un trabajo, pasa a estar sujeto a una compleja función que equilibra cientos de variables antes no disponibles (y a menudo datos aparentemente irrelevantes).

Con base en la combinación de estos puntos de datos que antes no estaban disponibles, estos complejos modelos nos colocan en una cohorte de personas que se considera lo suficientemente similares a nosotros como para afirmar que su comportamiento predice el nuestro, a menudo afectándonos como si en realidad hubiéramos actuado como ellos.

Este preocupante sistema secreto se está desplegando en paralelo a un proceso de continua privatización del conocimiento en general y de las tecnologías de IA en particular.

Este giro probabilístico sacude concepciones de certeza y causalidad que han estado en el centro de nuestra cosmovisión occidental y que, quizá desde la Ilustración, promovieron la adopción del método científico.

Como tal, el profundo giro probabilístico también está desestabilizando los pilares de nuestro sistema de derechos humanos. En particular, desestabiliza la idea de que los derechos humanos son inalienables y universales.

Los derechos humanos no pueden ser inalienables cuando nuestra capacidad para ejercerlos está mediada por máquinas probabilísticas. Esto es precisamente lo que ocurre, por ejemplo, cuando los sistemas automatizados de moderación de contenidos limitan lo que podemos expresar en las redes sociales.

La normalización de esta práctica ha llevado a los legisladores de la UE a codificarla en la ley, lo cual convierte la libertad de expresión en un derecho probabilístico que, dada la cantidad de falsos positivos, entiende que nuestra capacidad para ejercer la libertad de expresión está sujeta a una lotería.

El pilar de la universalidad, a su vez, se ve amenazado por la forma en que la IA está desplazando la atención del individuo al grupo y de un enfoque en la agencia y la responsabilidad por las acciones pasadas hacia un enfoque prospectivo que busca la reducción probabilística de daños futuros.

El sistema de organización social a través de derechos que se construyó con el individuo como elemento central está en crisis porque se ha cuestionado la relevancia del conjunto de características que se colocaron bajo la etiqueta de individuo, incluida la propia idea de autonomía individual.

Por ejemplo, esta visión probabilística del mundo dará a los jueces una confianza tecnológicamente infundida en su capacidad para predecir comportamientos futuros, lo que determinará sus sentencias.

Esto no se debe únicamente a la perspectiva prospectiva, sino a que la idea de la responsabilidad personal se diluirá por la normalización de un sistema que deriva cada vez más autoridad de su capacidad para procesar percepciones a nivel de población.

Se trata de un cambio respecto a la fundamentación de la autoridad en la capacidad de estudiar y comprender al individuo subyacente, la cual ha caracterizado a la mayoría de los sistemas judiciales modernos de los últimos siglos.

Por un lado, como señala Kathrina Geddes, esta transformación podría permitirnos reconocer la naturaleza sistémica de algunos de nuestros problemas sociales. Podría ayudarnos a desplazar el juicio moral desde el individuo al conjunto global de relaciones que definen la estructura social en su conjunto.

Por otro lado, la complejidad de las herramientas que se despliegan para operar a esta escala epistémica desafían la comprensión humana y, por tanto, crean espacio para la consolidación del poder en manos de una élite cada vez más reducida e incontrolable

Una élite que se reserva el derecho a interpretar los dichos de lo que parecería estar comercializándose como nuevos dioses de Silicio y un sistema que nos obliga a participar en una lotería constante que definirá lo que vemos en Internet, qué trabajos nos ofrecen, para qué relaciones estamos disponibles y si vamos o no a la cárcel.

Si hubiera espacio para reformular los valores que subyacen a estas tecnologías para ponerlas al servicio del interés público, los gobiernos tendrían que reafirmar su legitimidad democrática como arquitectos de las relaciones sociales y sustituir los incentivos de mercado que alimentan el desarrollo tecnológico por objetivos de interés público.

Las empresas dominantes se presentan como las únicas capaces de salvar al público del grave riesgo que suponen los complejos sistemas que ellas mismas han creado y que, según afirman, son demasiado complejos para ser auditados.

A menos que adoptemos una postura activa frente a estas tecnologías, este proceso remodelará nuestra forma de entender la identidad y convertirá nuestro sistema de derechos humanos en una lotería secreta.